L’intelligence artificielle (IA) est sans doute l’un des mots les plus utilisés aujourd’hui, aussi bien dans les médias que dans les entreprises. Assistants virtuels, voitures autonomes, traduction automatique, reconnaissance faciale : autant d’applications qui nourrissent l’idée que nous vivons une révolution sans précédent.

Pourtant, derrière ce terme devenu omniprésent, la réalité est plus nuancée. La plupart des technologies regroupées sous l’étiquette « intelligence artificielle » ne sont pas récentes. Elles existent depuis plusieurs décennies et ont évolué progressivement, au gré des avancées en puissance de calcul, en disponibilité des données et en efficacité des algorithmes.

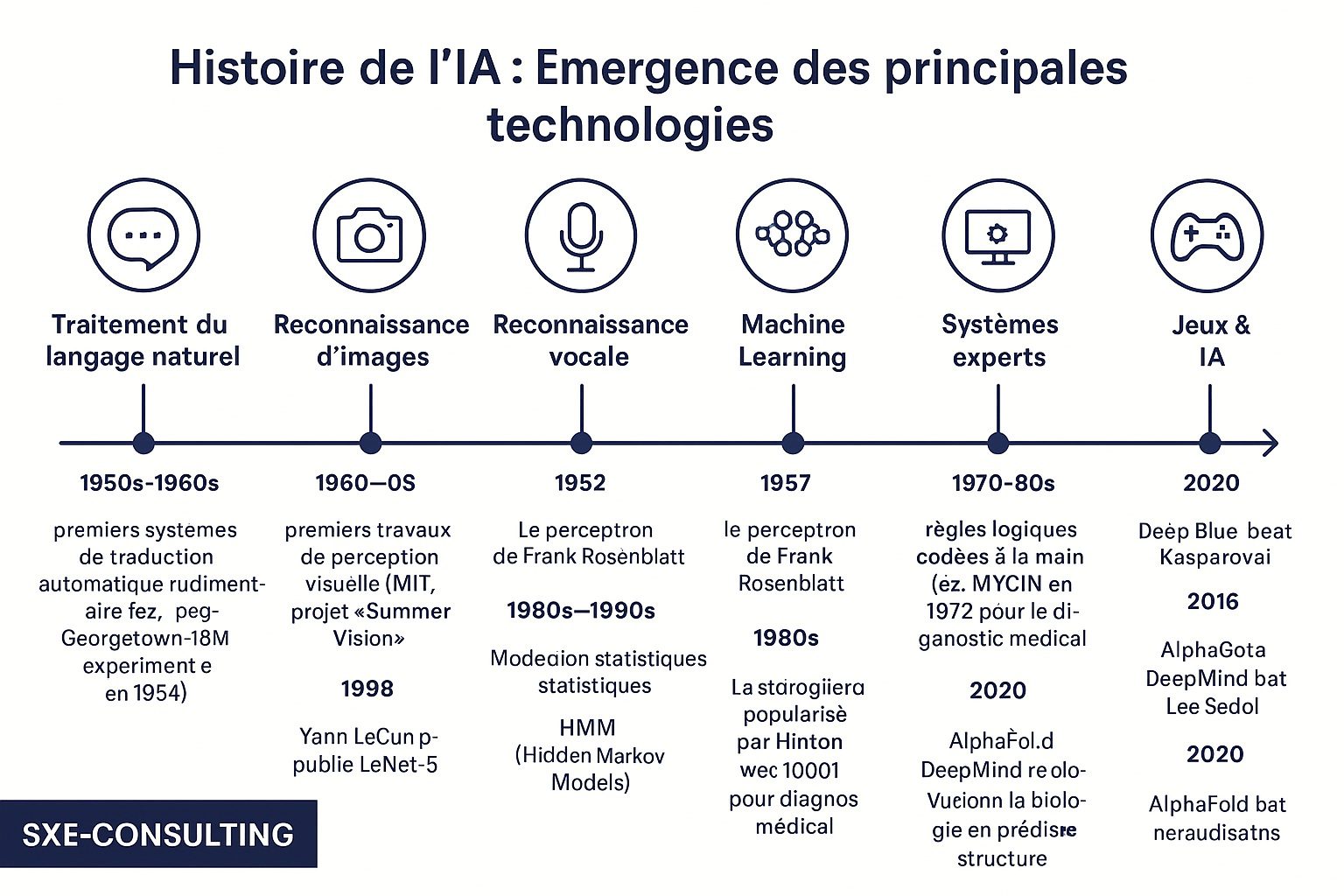

Cet article propose un panorama des principales briques technologiques de l’IA, en retraçant leurs origines et leur évolution.

Des débuts dans les années 1950

L’histoire de l’IA moderne commence dans les années 1950, une période où les premiers ordinateurs apparaissent. Alan Turing pose alors une question restée célèbre : « Les machines peuvent-elles penser ? ».

Dès cette époque, des chercheurs tentent de simuler certaines capacités humaines à l’aide de programmes : reconnaître des sons, analyser des images, ou encore résoudre des problèmes logiques. Quelques exemples :

-

Reconnaissance vocale : en 1952, Bell Labs présente « Audrey », une machine capable de reconnaître les chiffres prononcés par une voix humaine.

-

Vision artificielle : dans les années 1960, le MIT lance le projet « Summer Vision », une tentative pionnière de faire interpréter des images simples à un ordinateur.

-

Systèmes experts : dans les années 1970, des logiciels comme MYCIN permettent déjà d’assister les médecins dans le diagnostic de maladies infectieuses, en se basant sur des règles codées à la main.

Ces technologies restaient limitées par la puissance de calcul disponible à l’époque, mais elles ont jeté les bases de ce qui allait devenir l’IA.

Le Machine Learning : un long cheminement

Le machine learning, ou apprentissage automatique, est souvent présenté comme l’essence de l’IA moderne. Il consiste à concevoir des algorithmes capables d’apprendre à partir de données, sans être explicitement programmés pour chaque tâche.

Son histoire est jalonnée d’avancées :

-

1957 : Frank Rosenblatt met au point le perceptron, une forme primitive de réseau de neurones.

-

Années 1980–1990 : émergence des méthodes statistiques encore largement utilisées aujourd’hui, comme les arbres de décision, les réseaux bayésiens ou les machines à vecteurs de support (SVM).

-

2006 : Geoffrey Hinton et ses collègues relancent la recherche sur les réseaux neuronaux profonds (deep learning), en montrant qu’ils peuvent surpasser les approches traditionnelles.

Depuis, le machine learning s’est imposé comme un pilier incontournable des technologies modernes : de la reconnaissance vocale aux systèmes de recommandation, en passant par la prévision de la demande ou la maintenance prédictive.

La reconnaissance d’images : des laboratoires aux usages quotidiens

La reconnaissance d’images est aujourd’hui omniprésente : smartphones, caméras de sécurité, biométrie, inspection industrielle.

Cette technologie a connu une évolution progressive :

-

Dans les années 1990, Yann LeCun développe LeNet-5, un réseau neuronal convolutionnel conçu pour reconnaître des chiffres manuscrits.

-

Pendant près de 20 ans, ces modèles restent limités par la puissance de calcul et l’accès restreint aux données.

-

En 2012, un tournant décisif survient avec AlexNet, qui remporte le concours ImageNet en pulvérisant les performances des approches classiques.

Depuis cette percée, les réseaux neuronaux convolutionnels dominent le domaine, permettant des applications allant du diagnostic médical à la conduite autonome.

Le traitement du langage naturel : de la statistique au deep learning

Le traitement du langage naturel (NLP – Natural Language Processing) est l’une des branches les plus visibles de l’IA actuelle, avec les assistants virtuels et les chatbots.

Mais là encore, les origines remontent loin :

-

En 1954, l’expérience Georgetown-IBM traduit automatiquement une soixantaine de phrases du russe vers l’anglais.

-

Dans les années 1990, les modèles statistiques probabilistes deviennent dominants.

-

En 2017, l’architecture Transformer change la donne, ouvrant la voie à des modèles géants comme BERT, GPT ou LLaMA.

Ces modèles sont capables de générer des textes cohérents, de traduire, de résumer ou encore de répondre à des questions complexes. Ils reposent sur l’apprentissage à partir de milliards de phrases et sur des puissances de calcul inédites.

Reconnaissance vocale : une évolution discrète mais constante

La reconnaissance vocale est un autre domaine qui a beaucoup évolué :

-

En 1952, « Audrey » reconnaît seulement des chiffres.

-

Dans les années 1980, les modèles à Hidden Markov Models (HMM) améliorent considérablement la précision.

-

Dans les années 2010, les réseaux neuronaux révolutionnent le domaine, donnant naissance à Siri (2011), Alexa (2014) et Google Assistant (2016).

Aujourd’hui, la reconnaissance vocale alimente aussi bien les assistants personnels que les applications industrielles, notamment pour les opérateurs en production.

L’IA dans les jeux : des jalons historiques

Les jeux constituent un terrain d’expérimentation privilégié pour l’IA :

-

En 1997, Deep Blue d’IBM bat Garry Kasparov aux échecs.

-

En 2016, AlphaGo de DeepMind surprend le monde en battant Lee Sedol, l’un des meilleurs joueurs de Go.

-

En 2020, AlphaFold résout un problème majeur de biologie en prédisant la structure des protéines avec une précision inédite.

Ces jalons montrent que l’IA n’est pas seulement une technologie appliquée, mais aussi un outil de recherche scientifique.

Pourquoi l’IA est-elle si visible aujourd’hui ?

Si l’IA occupe aujourd’hui une telle place dans nos vies, ce n’est pas parce qu’elle est « nouvelle », mais parce que plusieurs conditions favorables se sont réunies :

-

La puissance de calcul : les GPU et les processeurs spécialisés permettent d’entraîner des modèles complexes.

-

La disponibilité des données : internet, capteurs et objets connectés produisent des volumes colossaux de données.

-

Les algorithmes modernes : en particulier les architectures neuronales profondes comme les Transformers.

-

La démocratisation : les outils sont accessibles au grand public, via des API, des logiciels open source et même des applications sur smartphone.

C’est cette combinaison qui explique l’explosion récente des applications visibles de l’IA.

Conclusion

L’intelligence artificielle est souvent présentée comme une rupture soudaine, mais elle est en réalité l’aboutissement de plus de soixante-dix ans de recherche. Reconnaissance vocale, vision artificielle, traitement du langage naturel, apprentissage automatique : toutes ces briques existaient déjà, parfois de manière rudimentaire, dès les années 1950.

Ce qui change aujourd’hui, c’est l’échelle, la maturité des algorithmes et leur intégration dans notre quotidien. Plutôt qu’une mode passagère, l’IA est le résultat d’une évolution progressive, qui transforme désormais en profondeur l’industrie, les services et la recherche scientifique.